반응형

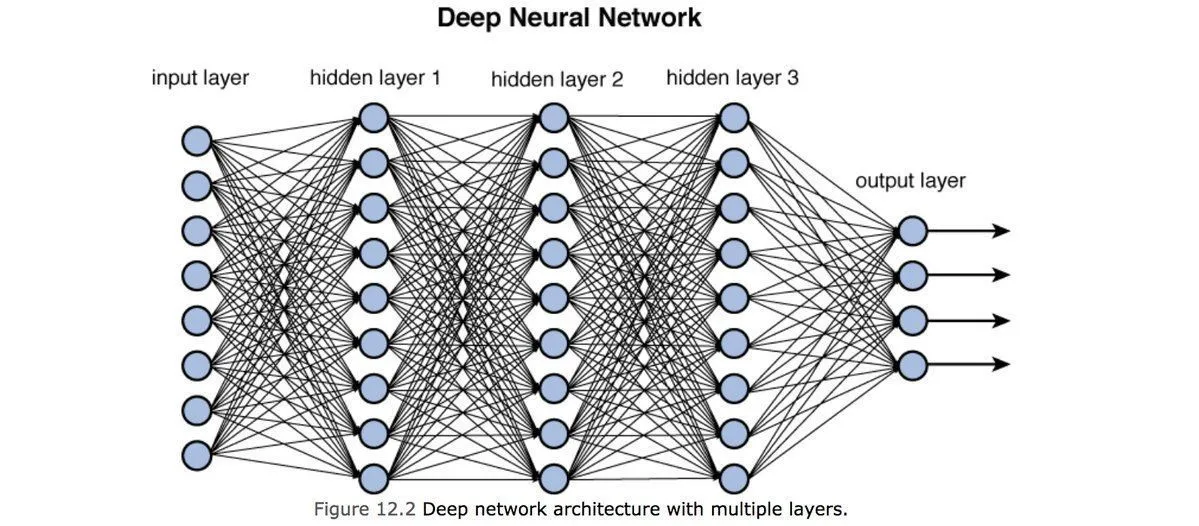

심층 신경망(Deep Neural Network)

- 심층 신경망은 입력층(Input Layer)과 출력층(Output Layer) 사이에 3개 이상의 은닉층(Hidden Layer)이 중첩으로 이뤄진 인공신경망으로, 일반적인 인공신경망과 마찬가지로 복잡한 비선형 관계(Non-linear Relationship)들을 모델링할 수 있다.

- 예를 들어 사물 식별 모델을 위한 심층 신경망 구조에서 각 객체가 이미지 기본 요소들의 계층적 구성으로 표현될 수 있다. 이때 추가 계층들은 점진적으로 모여진 하위 계층들의 특징들을 규합시킬 수 있는데, 이런 특징은 비슷하게 수행된 인공신경망에 비해 더 적은 수의 유닛(Node)들 만으로도 복잡한 데이터를 모델링할 수 있게 해준다.

- 기존의 인공신경망과 같이 심층 신경망이 단순하게 학습될 경우 과적합과 높은 시간 복잡도등의 문제들이 발생할 수 있다.

심층 신뢰 신경망(Deep Belief Network)

- 심층 신뢰 신경망(DBN)은 입력층과 하나의 은닉층으로 구성되어 있는 제한 볼츠만 머신(RBM, Restricted Boltzmann Machine)을 여러 층으로 쌓아 올린 형태의 신경망으로, 입력 데이터와 같은 출력을 재생성하는 모델이다.

- 계층 간에는 연결이 있지만 계층 내의 유닛 간에는 연결이 없다는 특징이 있다.

- 신경망의 레이어가 늘어날수록 오래 전 데이터에서 기울기가 사라지는 문제가 발생하는데, 이 문제를 해결하기 위해 DBN에서는 입력으로부터 가까운 층부터 차례대로 비지도 학습인 RBM을 기반으로 여러 번의 사전 학습을 통해 가중치를 어느 정도 보정하는 사전 학습을 수행하는데 이를 층별 선훈련(Layer-wise Pre-training)이라고 한다.

- DBN에서 1단계 RBM의 사전 학습이 완료되면 그 결괏값이 2단계 RBM의 입력값으로 사용되며, 이때 1단계에서 사용된 가중치는 고정된다. 이와 같은 방법으로 마지막 은닉층까지 순서대로 반복되며, 이런 층별 선훈련의 목적은 각 은닉층에 존재하는 가중치를 가능한 한 목푯값에 가깝도록 만드는 것이다.

- DBN은 입력 데이터와 같은 출력 데이터를 재생성함으로 오토인코더나 분류기 등에 활용될 수 있으며, 이미지에서 사람의 얼굴 방향 인식 문제나 문서의 코드화 작업 등에 사용되고 있다.

합성곱 신경망(Convolutional Neural Network)

- 비전 분야에서 다층 퍼셉트론(MultiLayer Perceptron)을 이용하면 이론적으로 학습은 가능하지만, 영상의 크기가 커질수록 학습해야 하는 데이터의 크기나 학습 시간이 매우 커지며 이미지의 변화에도 취약해지는 단점을 가진다.

- 이런 문제를 해결하기 위해 고안된 지도 학습 알고리즘인 컨볼루션 신경망(CNN)은 인간의 시신경 구조를 모방하여 만들어졌으며, 특징을 추출하는 일종의 필터인 컨볼루션 커널(Convolution kernel)을 도입하여 입력된 이미지를 분류하기 위한 변별적 학습을 수행한다.

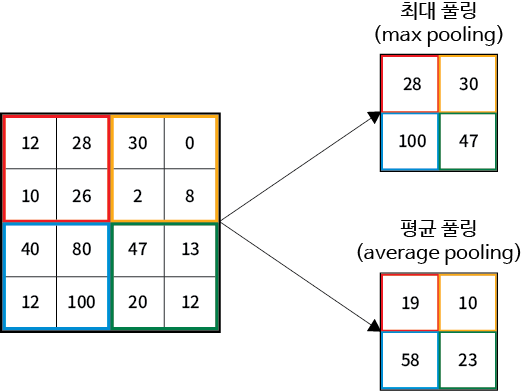

- 최대 풀링(Max pooling)과 평균 풀링(Average pooling)과 같은 서브 샘플링을 통해 이웃하고 있는 데이터 간의 대비율을 높이고 처리해야 할 데이터의 양을 줄여준다.

- 컨볼루션 커널을 이용한 필터링 단계와 풀링을 이용한 서브 샘플링 단계를 여러 번 반복함으로써 CNN은 이미지의 위치나 각도 변화 등에도 변함없이 강건함(Topology Invariance)을 유지할 수 있다.

- 컨볼루션 신경망(CNN)은 이미지의 추상적인 특징을 여러 관점에서 추출함으로써 위치에 무관한 특징을 추출하고, 학습해야 할 전체 매개변수의 수를 감소시켜 빠른 학습 속도와 우수한 일반화 능력을 가질 수 있도록 도와준다.

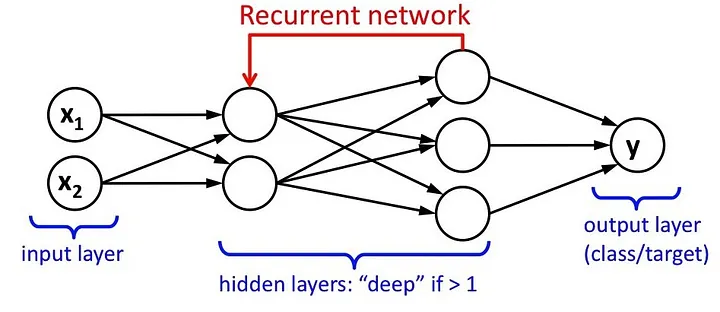

순환 신경망(Recurrent Neural Network)

- 순환 신경망은 인공신경망을 구성하는 유닛 사이의 연결이 Directed cycle을 구성하는 신경망을 말한다.

- 순환 신경망은 앞먹임 신경망과 달리 임의의 입력을 처리하기 위해 신경망 내부의 메모리를 활용할 수 있다. 이러한 특성에 의해 순환 신경망은 필기체 인식과 같은 분야에 활용되고 있고 높은 인식률을 나타낸다.

제한 볼츠만 머신 (Restricted Boltzmann Machine)

- 볼츠만 머신에서 층간 연결을 없앤 형태의 모델로, 층간 연결을 없애면 머신은 다시 유닛(Visible Unit)과 은닉 유닛(Hidden Unit)으로 이루어진 무방향 이분 그래프 형태의 모양이 된다.

- 모델의 층간 연결을 없앰으로써 뉴럴 네트워크는 깊어질 수 있다는 이점이 있으며, 또한 가시 유닛이 관찰되고 고정되었을 때 은닉 유닛을 추론하는 MCMC 과정이 단 한 번에 끝난다는 장점이 있다.

심층 Q-네트워크(Deep Q-Networks)

- 강화 학습을 위한 가장 최신 딥 러닝 모델로, 행동심리학에서 영감을 받았으며, 어떤 환경 안에서 정의된 에이전트가 현재의 상태를 인식하여, 선택 가능한 행동들 중 보상을 최대화하는 행동 혹은 행동 순서를 선택하는 방법이다.

- 강화 학습에서 다루는 환경은 주로 마르코프 결정 과정으로 주어진다. 또한 입출력 쌍으로 이루어진 훈련 집합이 제시되지 않으며, 잘못된 행동에 대해서도 명시적으로 정정이 일어나지 않는다는 점에서 일반적인 지도 학습과 다르다.

Reference

반응형

'Data > Ai' 카테고리의 다른 글

| 딥러닝 프레임워크들 - 텐서플로우, 케라스, 토치 (0) | 2023.06.18 |

|---|---|

| 딥러닝의 개념과 동작 방식 - 인공신경망 (0) | 2023.06.18 |

| 머신러닝 알고리즘 - SVM, 의사 결정 나무, K-means 군집화 (0) | 2023.06.18 |

| 머신러닝의 분류 - 지도와 비지도, 강화 학습 (0) | 2023.06.18 |

| 머신러닝의 개념과 동작 방식 - 벡터와 특징 추출 (0) | 2023.06.18 |